기초적인 자연어 처리를 위해 데이터를 수집하는 경우 신문기사와 더불어 위키 덤프(wiki dump)를 많이 활용합니다.

오늘은 위키덤프를 다운로드 받고 파싱하여 txt형태로 저장하는 방법을 소개합니다.

1. 한글 위키 덤프 파일 다운로드

아래 링크를 통해 내용만 담긴 가장 최신 데이터를 받으실 수 있습니다.

http://dumps.wikimedia.org/kowiki/latest/kowiki-latest-pages-articles.xml.bz2

다른 한글 위키 덤프 파일의 경우 아래 링크에서 받으실 수 있습니다.

위키백과:데이터베이스 다운로드 - 위키백과, 우리 모두의 백과사전

위키백과, 우리 모두의 백과사전. 위키백과의 자료를 여러가지 용도로 이용하려는 사람들을 위해, 위키백과에서는 주기적으로 전체 문서를 묶어서 배포하고 있습니다. 여기에서 한국어 위키백과 덤프를 받을 수 있습니다. pages-articles.xml.bz2 - 일반 문서의 최신 버전만이 묶여 있고, 전체 편집 역사는 들어있지 않습니다. 대부분의 이용자는 이 파일을 이용하면 됩니다. pages-current.xml.bz2 - 모든 문서의 최신 버전이 묶여 있습니

ko.wikipedia.org

2. WikiExtractor 설치

https://github.com/attardi/wikiextractor

attardi/wikiextractor

A tool for extracting plain text from Wikipedia dumps - attardi/wikiextractor

github.com

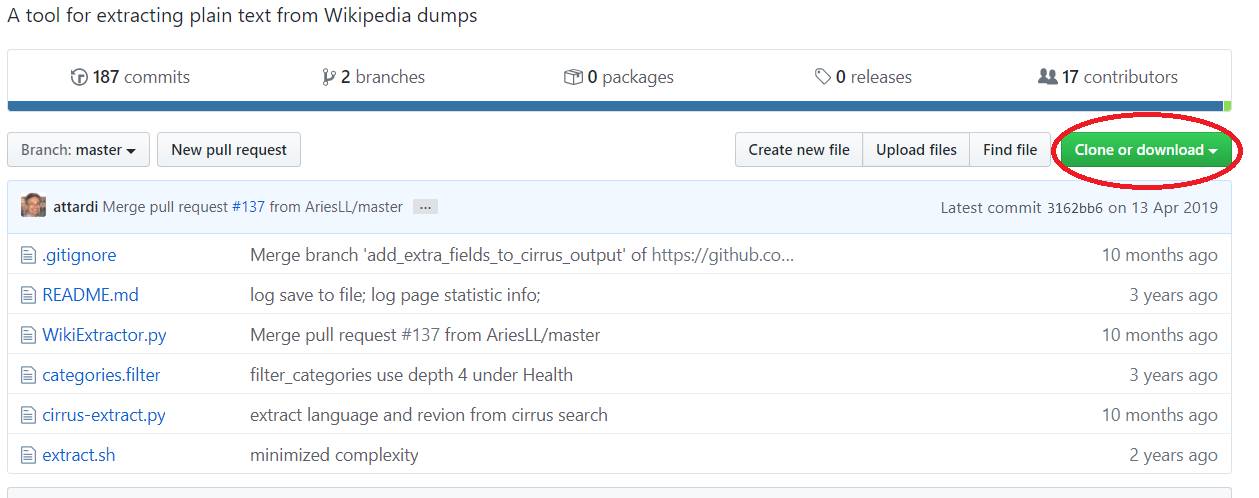

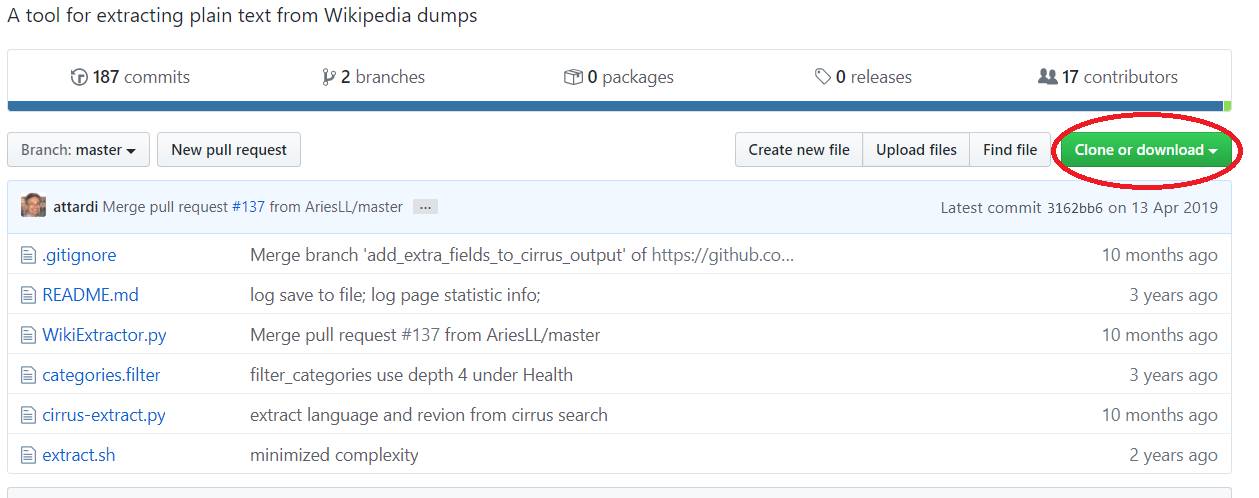

위 github에 접속하여 붉은 원으로 둘러쌓인 부분을 누르시면 깃 주소를 복사하실 수 있습니다.

3. Extract

위키덤프가 저장된 공간에서 cmd를 열어주신 다음 "git clone (복사한 주소)'를 입력하면 클론파일이 생성됩니다.

설치된 WikiExtractor.py가 있는 공간에 위키 덤프 파일을 넣어주신다음 bash를 열어

python WikiExtractor.py kowiki-latest-pages-articles.xml.bz2

를 입력해주시면 자동으로 추출이 시작됩니다.