[GO/Golang]selenium없이 Webdriver 사용하기

2020. 6. 20. 16:26

Programming/Go

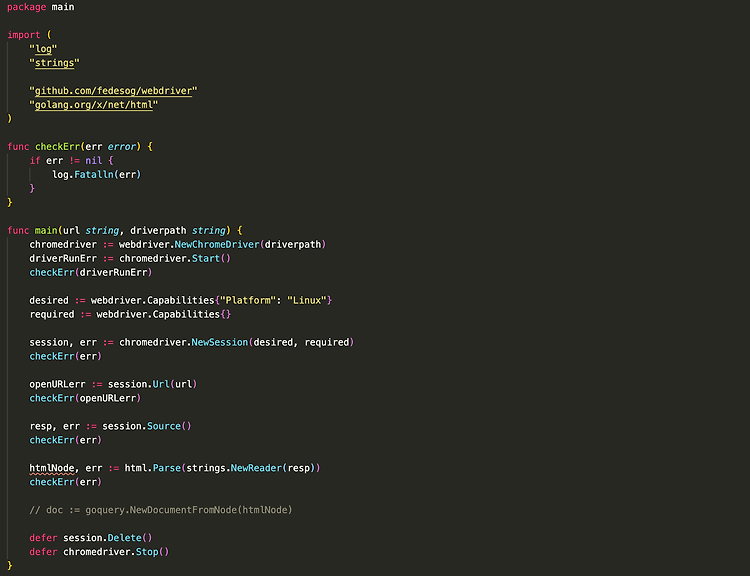

1. Webdriver WebDriver는 사용자 에이전트를 검사하고 제어할 수 있는 원격 제어 인터페이스입니다. 프로세스 외부의 프로그램이 웹 브라우저의 동작을 원격으로 지시할 수 있어 웹 자동화를 가능하게 합니다. 웹 문서에서 DOM을 발견하고 조작하고 사용자 에이전트의 동작을 제어하기 위한 인터페이스 세트가 제공됩니다. 따라서 주로 웹 제작자가 별도의 제어 프로세스에서 사용자 에이전트를 자동화하는 테스트를 작성하는 데 사용하지만, 보통 인공지능 학습을 위한 데이터셋 준비 등 웹 크롤링에 자주 사용됩니다.(페이지 스크립트 구동이 필요한 경우 html 파싱만으로 읽을 수 없는 요소들이 있기 때문) 셀레니움이 웹드라이버 API를 제공하고 있으며, go에서도 셀레니움 라이브러리가 있지만 셀레니움 라이브러리..

[python]웹 크롤링(crawling) - Riss 논문 검색 데이터를 csv파일로 저장하기

2020. 1. 11. 14:35

Data/Data Engineering

다중 스레드를 활용한 Riss 논문 데이터 크롤러에 관한 링크입니다. [python]파이썬 동시성/비동기 프로그래밍 5. 활용 예시 Riss Crawler 만들어서 Riss 논문 데이터 다운로 파이썬 동시성/비동기 프로그래밍 4. concurrent.futures [Python]파이썬 동시성/비동기 프로그래밍 4. concurrent.futures 파이썬 동시성/비동기 프로그래밍 3. GIL(Global interpreter Lock) [Python]파이썬 동.. leo-bb.tistory.com 현 문서와의 차이점 1. 동시성을 이용해 속도 증가 2. 쉬운 사용법과 간결함 3. 비제한적 크롤링에 관한 전반적인 방법은 이전 글을 참고해주시기 바랍니다. Basic Riss crawl 어떤 목적을 가지고 연..

[Python]자연어 처리를 위한 데이터 수집 웹 크롤링-1(crawling)

2020. 1. 5. 20:34

Data/Data Engineering

NLP를 위해 데이터를 수집하는데 있어 우리는 많은 데이터를 인터넷을 통해 구하게 됩니다. 그러한 데이터의 양이 적당히 적은 수준이라면 충분히 반복작업을 통해 사용자가 직접 데이터를 수집할 수 있습니다. 그러나 그 양이 방대해지는 경우 단순히 데이터 수집에만도 수많은 시간 투자가 요구됩니다. 이렇게 Web상에 존재하는 Contents를 수집하는 작업을 크롤링(crawling)이라 합니다. 본문에서는 파이썬을 통해 이러한 크롤링을 효율적으로 수행하는 방법을 소개합니다. 예시 코드는 매경스포츠(MKsport) 사이트에서 NBA를 검색한 결과의 기사 본문을 크롤링 하는 코드입니다. 오늘 예제에서는 beautifulsoup4 라이브러리와 request 라이브러리가 필요합니다. from bs4 import Bea..